En un mundo cada vez más articulado mediante la inteligencia artificial (IA), el etiquetado de contenidos generados por esta tecnología se ha convertido en una necesidad imperativa para garantizar la transparencia y combatir la desinformación.

Desde la Unión Europea (UE) hasta China, diversas naciones y regiones han implementado regulaciones que exigen la identificación clara de videos creados con IA, especialmente deepfakes, para proteger a los usuarios de posibles manipulaciones. A continuación, se exploran las implicaciones éticas y legales de estas medidas, y se destacan los casos controvertidos y la importancia de fomentar un uso responsable de la tecnología en la comunicación digital.

Cómo se etiquetan los contenidos generados con IA

El etiquetado de videos producidos con IA está regulado en varias zonas del mundo. En la UE, el Reglamento Europeo de IA, aprobado en 2024, establece la obligatoriedad de etiquetar contenidos creados por IA, lo que incluye los videos, para garantizar la transparencia y combatir la desinformación.

España, por ejemplo, ha adaptado esta normativa mediante un anteproyecto de ley que refuerza la identificación de videos creados con IA, con especial atención a los deepfakes. En China, la Administración del Ciberespacio ha implementado regulaciones similares, hasta el punto de exigir que todo contenido generado por IA esté claramente etiquetado mediante metadatos o descripciones explícitas. Estas medidas buscan fomentar la confianza en el entorno digital y proteger a los usuarios de posibles manipulaciones.

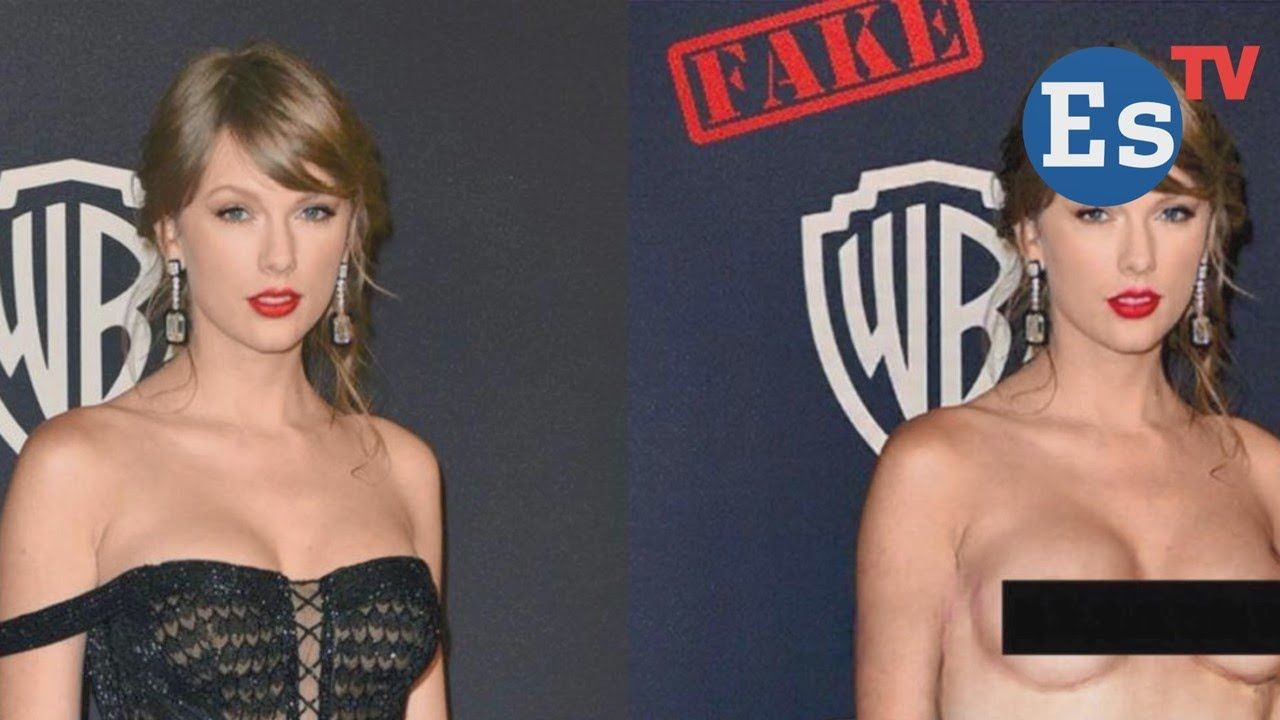

¿Y por qué es tan importante etiquetar videos generados con IA? El valor de esta medida radica en su capacidad para proteger a las audiencias de la manipulación y la desinformación. Una muestra de este riesgo es que, en ocasiones, los deepfakes han sido utilizados para crear videos falsos de figuras públicas, lo que puede tener consecuencias graves en contextos políticos o sociales.

El anteproyecto que busca regular los contenidos en España

El Consejo de Ministros ha presentado el anteproyecto de Ley para el Buen Uso y la Gobernanza de la Inteligencia Artificial (IA), que busca regular esta tecnología en España conforme al Reglamento Europeo. Este texto, aún en consulta pública, establece qué aplicaciones están prohibidas, cuáles requieren supervisión y cuáles pueden utilizarse sin restricciones. Entre las medidas más destacadas, se encuentra la obligación de etiquetar contenidos generados con IA. Cuando los sistemas de IA generen contenido sintético de audio, imagen, video o texto, se deberá “marcar los resultados de salida de tal modo que pueda detectarse su naturaleza artificial”, señala el documento.

El anteproyecto sigue el enfoque europeo de clasificación de riesgos: los sistemas de “riesgo inaceptable” estarán prohibidos, como aquellos que manipulen a las personas o infieran emociones sin consentimiento. Los de “alto riesgo” incluirán, entre otros, los sistemas de identificación biométrica y los relacionados con educación, empleo o servicios públicos. Finalmente, los de “bajo riesgo” no estarán sujetos a restricciones. También se contempla la creación de un registro nacional para los sistemas de IA de alto riesgo y la supervisión por parte de la Agencia Española de Supervisión de la Inteligencia Artificial (AESIA).

Una de las áreas más controvertidas de este anteproyecto de ley es el uso del reconocimiento facial en tiempo real. El anteproyecto establece que estos sistemas “están prohibidos, salvo que su uso sea estrictamente necesario” y solo en casos específicos, como la búsqueda de víctimas de trata o la prevención de atentados terroristas. Las solicitudes para utilizarlos deberán ser evaluadas por los juzgados de lo contencioso-administrativo en un plazo máximo de 48 horas. Además, la Agencia Española de Protección de Datos (AEPD) será la responsable de la gestión de datos biométricos.

El incumplimiento de esta normativa comportará sanciones que van desde los 6.000 euros hasta los 35 millones de euros, dependiendo de la gravedad de la infracción. No etiquetar contenidos generados por IA será considerado una infracción grave, con multas de hasta el 3% del volumen de negocio anual de la empresa infractora. Sin embargo, las sanciones a autoridades públicas serán más laxas, lo que ha generado críticas de expertos como Borja Adsuara, especialista en derecho digital, quien ha declarado al diario El País que “con la IA pasará lo mismo” que con los datos personales: la Administración no será castigada de manera efectiva.

¿Y cuál es la motivación que explica los deepfakes?

El repertorio de motivaciones es diverso y van desde la manipulación política hasta el entretenimiento. Por ejemplo, se han generado videos de Donald Trump y Elon Musk en los que parecen hacer declaraciones controvertidas que nunca ocurrieron. También se han creado falsificaciones digitales de la cantante Taylor Swift, hasta el punto de que se han simulado actuaciones o entrevistas ficticias de la actual diva del pop. Estos casos ilustran cómo esta tecnología puede ser empleada para influir en la opinión pública, provocar ganancias fraudulentas o simplemente confundir a las audiencias. La creciente accesibilidad de estas herramientas plantea desafíos importantes para la seguridad digital y la confianza en los medios.

El video patrio de La isla de las corrupciones del PP

A principios de marzo, el Partido Popular colgaba en sus redes sociales un video titulado La isla de las corrupciones, donde parodiaba el reality show La isla de las tentaciones y utilizaba inteligencia artificial para recrear a figuras destacadas del PSOE en un contexto ficticio de corrupción. Entre los personajes representados estaban Pedro Sánchez, presidente del Gobierno; Begoña Gómez, su esposa; José Luis Ábalos, exministro de Transportes; y Francina Armengol, presidenta del Congreso. El video buscaba criticar al PSOE y sus presuntos casos de corrupción, pero su tono satírico y el uso de IA generaron una fuerte controversia.

Las reacciones fueron variadas y contundentes. Desde el ámbito político, el PSOE calificó el video como un ataque desproporcionado y poco ético. Además, el Gobierno de República Dominicana expresó su descontento, ya que el video utilizaba imágenes del país y lo asociaba con el término “corrupciones”, lo que fue percibido como una falta de respeto. Ante la presión y las críticas, el PP decidió retirar el video de sus plataformas oficiales, aunque ya se había viralizado ampliamente en redes sociales.

Este caso pone de manifiesto los desafíos éticos y políticos del uso de inteligencia artificial en campañas de comunicación. La polémica no solo evidenció tensiones entre los dos partidos políticos con más respaldo popular en nuestro país, sino que también abrió un debate sobre los límites del humor político y la responsabilidad en el uso de tecnologías avanzadas para crear contenido.

Al etiquetar estos videos, se reduce el riesgo de que las personas sean engañadas y se promueve un uso más ético de la tecnología. Además, esta práctica pone el foco sobre la responsabilidad de las empresas tecnológicas y los creadores de contenido, quienes deben garantizar que los usuarios puedan distinguir entre contenido real y sintético

¿Qué quiere decir etiquetar como creado con IA?

Etiquetar como creado con IA significa identificar contenido que ha sido generado por inteligencia artificial. Esta práctica asegura transparencia y posibilita a los usuarios saber cuándo un texto, imagen, sonido u otro tipo de contenido se ha producido mediante tecnología automatizada en lugar de la intervención directa de humanos. La etiqueta no solo fomenta la confianza, sino que también ayuda a diferenciar el trabajo generado por máquinas del realizado por personas. Es un paso hacia una comunicación ética y responsable en el mundo digital.

¿Cómo saber si un video fue generado por IA?

Detectar si un video fue generado por inteligencia artificial puede ser un reto, pero hay ciertos indicios que pueden ayudarte. Aquí van algunas pautas a tener en cuenta:

Identifica detalles poco naturales. Fíjate si los movimientos de las personas o los objetos parecen extraños, robóticos o demasiado perfectos.

Detecta inconsistencias visuales. Busca imperfecciones en la iluminación, sombras que no concuerden o artefactos en la textura de objetos o piel.

Analiza críticamente la sincronización labial. En videos de personas hablando, verifica si el movimiento de los labios coincide con el audio.

Rastrea cuáles son sus metadatos. Analiza los metadatos del archivo del video para localizar información sobre su creación.

Emplea herramientas de análisis que posibiliten calibrar su naturaleza de IA. Hay programas y plataformas diseñados para identificar contenido generado por IA, analizando patrones que no suelen ser visibles a simple vista.

Herramientas para detectar contenido generado con IA

La buena noticia es que la tecnología mejora constantemente, por lo que también se están desarrollando métodos avanzados para identificar este tipo de contenido. En cualquier caso, la atención al detalle es clave. A continuación, se espigan algunos de los instrumentos más destacados en ese cometido:

- Amazon Rekognition. Ofrece análisis de imágenes y videos en tiempo real, de manera que examina imágenes y videos, identificando objetos, rostros, texto y actividades mediante inteligencia artificial.

- Google Cloud Video Intelligence. Detecta escenas, objetos y anomalías en videos mediante aprendizaje automático avanzado.

- Microsoft Azure Video Indexer. Proporciona análisis detallado de contenido visual, incluyendo reconocimiento facial y de emociones.

- Clarifai. Esta herramienta está especializada en análisis de imágenes y videos, con capacidades de detección de contenido generado por IA.

En síntesis: si pensamos en clave de generaciones presentes y futuras, el etiquetado de videos generados con IA es crucial para preservar la confianza en los medios digitales y proteger la integridad de la información. Por ejemplo, en el ámbito educativo, los estudiantes podrían ser expuestos a contenido manipulado si no se implementan medidas de etiquetado adecuadas, lo que afectaría su capacidad para desarrollar un pensamiento crítico. Asimismo, en el ámbito legal, la identificación de videos generados con IA puede ser determinante para evitar fraudes o pruebas falsas en juicios. En definitiva, esta acción no solo beneficia a los usuarios actuales, sino que también sienta las bases para un ecosistema digital más seguro y confiable en el futuro.